Latency is a key factor affecting application delivery, particularly in data-intensive environments like AI applications, where responsiveness and speed are crucial. The inability to handle latency effectively can lead to performance issues, reduced availability, and limited scalability, especially as applications grow and user demands fluctuate. Latency bottlenecks result from various issues, such as suboptimal data routing, inefficient processing, and inadequate resource allocation.

Consequences of the Inability to Handle Latency

Impact on Performance

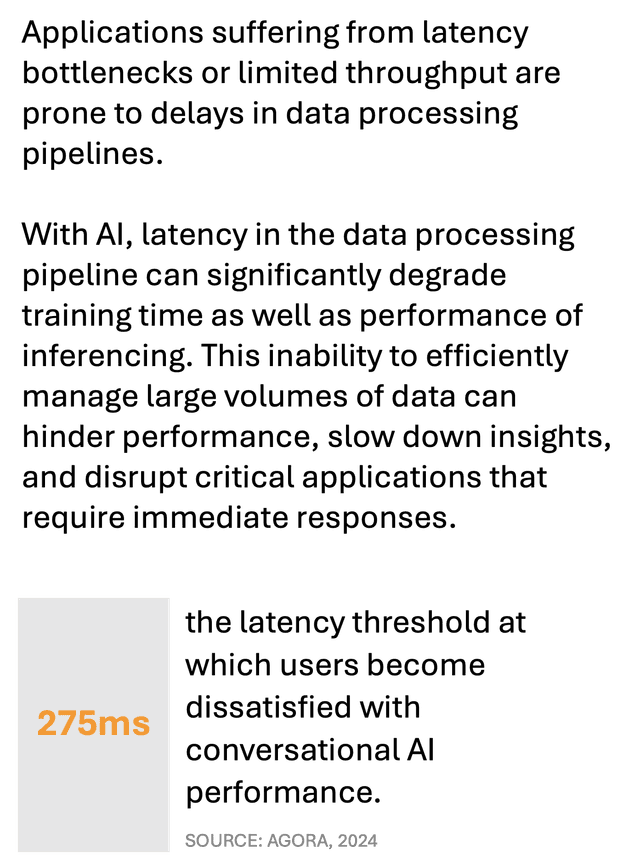

High latency negatively impacts application performance by increasing response times and slowing down data processing. For AI applications, where real-time data processing is essential, latency can degrade the performance of both training and inferencing tasks. When applications fail to handle latency efficiently, tasks are processed more slowly, resulting in sluggish user experiences.

According to a recent Netskope report, 43% of user experience issues were attributed to high latency, underscoring how significantly latency affects performance. Properly managing latency is essential for maintaining fast response times and delivering a smooth user experience, especially for applications that rely on rapid data transfers and low latency processing.

Impact on Availability

Latency-related issues can also impact application availability, as delayed data transfers and inefficient routing may lead to service disruptions. In distributed environments, where applications rely on multiple components functioning together, high latency can cause cascading failures.

For example, if one service is slow to respond, it can delay other interconnected services, resulting in downtime and reduced availability. When systems lack the ability to quickly route data or adjust processing based on real-time conditions, they become prone to interruptions that prevent users from accessing services as needed. Maintaining low latency is vital for ensuring consistent availability, particularly in environments where applications must remain operational around the clock.

Impact on Scalability

Latency constraints limit an application’s scalability by preventing the system from handling increased demand effectively. As user traffic grows, the inability to manage latency can lead to processing bottlenecks, reducing the system’s capacity to scale dynamically. This is especially relevant for AI applications that process large volumes of data; if latency is not managed, the infrastructure may not be able to accommodate additional workloads, which stifles scalability.

In cloud environments, latency issues can prevent applications from leveraging distributed resources efficiently, making it difficult to handle traffic spikes or support expansion into new regions. Optimized latency management supports scalability by ensuring that the application can quickly respond to changing demands without excessive delays.

Impact on Operational Efficiency

Latency issues reduce operational efficiency by increasing the resources required to handle standard workloads. When systems experience high latency, more computational power, memory, and bandwidth are needed to process requests, as tasks take longer to complete. This leads to higher operational costs and greater resource consumption, as organizations must allocate additional resources to maintain acceptable performance levels.

Additionally, latency-related issues require more frequent troubleshooting and intervention from IT teams, increasing operational overhead. Efficient latency management reduces resource usage and operational costs, enabling teams to focus on value-adding activities rather than constant maintenance and troubleshooting.

Best Practices for Mitigating Latency Challenges

To address latency issues, organizations should adopt solutions such as optimized data routing, edge computing, and adaptive resource allocation. These practices help reduce latency, improve performance, and ensure that the infrastructure can scale efficiently.

Optimized Data Routing

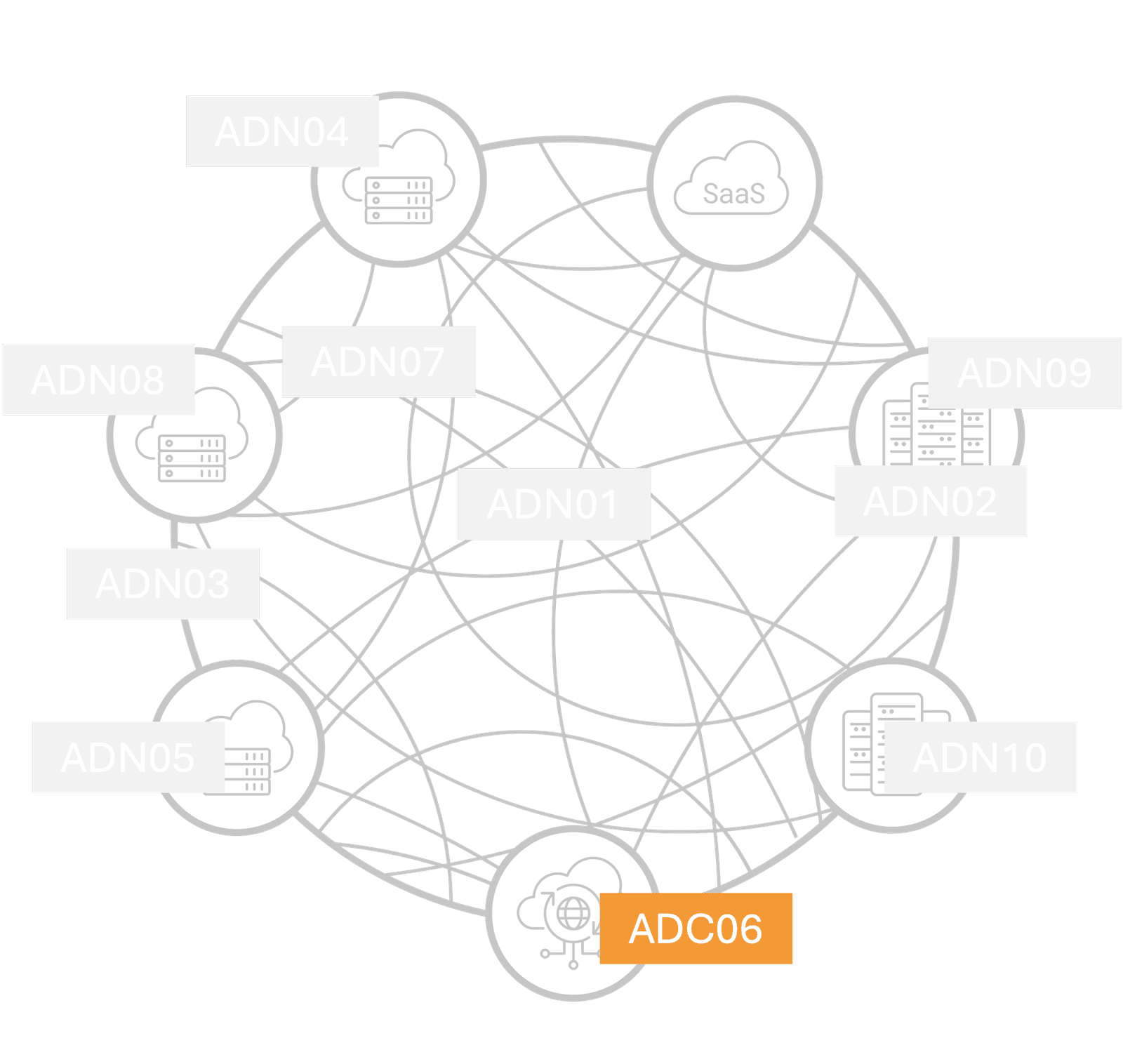

Optimized data routing improves performance and availability by ensuring that data travels the shortest, most efficient paths to reach its destination. Tools like software-defined wide area networks (SD-WANs) enable dynamic routing based on real-time network conditions, such as bandwidth availability and server health. By automatically adjusting data paths, optimized routing minimizes latency and ensures that traffic flows efficiently across the infrastructure, enhancing both performance and scalability.

Edge Computing

Edge computing reduces latency by processing data closer to the user, rather than relying solely on centralized data centers. By deploying edge nodes to handle time-sensitive tasks, organizations can minimize the distance data must travel, reducing delays. Businesses leveraging edge computing have experienced improved response times and enhanced reliability due to reduced data travel distances (Schneider Electric). This approach is particularly useful for AI applications and IoT environments, where real-time data processing is crucial.

Edge computing also supports scalability by offloading processing tasks from the central servers, freeing up resources to handle additional traffic.

Adaptive Resource Allocation

Adaptive resource allocation uses real-time data and machine learning models to predict traffic patterns and allocate resources accordingly. This approach ensures that applications have the necessary processing power and bandwidth to manage peak demand without incurring excessive latency. In cloud environments, adaptive resource allocation can dynamically scale resources based on current load, maintaining low latency even during traffic spikes. By leveraging predictive analytics, organizations can ensure that their infrastructure is both efficient and responsive, improving operational efficiency and reducing the impact of latency on performance and scalability.

Conclusion

The inability to handle latency effectively impacts application performance, availability, scalability, and operational efficiency. By implementing optimized data routing, edge computing, and adaptive resource allocation, organizations can mitigate latency challenges and support a high-performance, resilient infrastructure.

Prioritizing latency management is essential for maintaining a responsive user experience, ensuring consistent availability, and enabling scalable growth. In today’s competitive digital landscape, investing in strategies to reduce latency is critical for delivering reliable and efficient application services.