As businesses explore ways to harness the power of AI, many are turning to large language models (LLMs) to improve their decision making. Yet LLMs such as ChatGPT are trained on vast amounts of public data available across the Internet, limiting their usefulness for enterprises that want to use AI to capture insights from their own corporate data. Moreover, it can require months and a lot of expense to train those models, which makes it virtually impossible to ensure that every response is truly meaningful and up to date.

The question is how can businesses leverage natural language processing to obtain powerful and up-to-date AI insights from their own company-specific data? Building their own LLM is prohibitively expensive. So, too, is fine-tuning an existing one with specialized data.

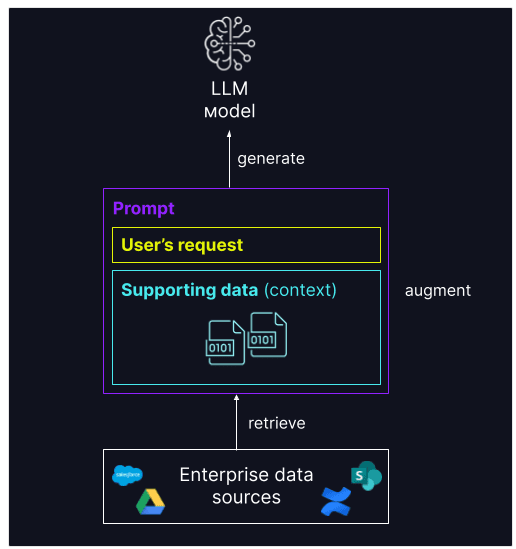

Thankfully, retrieval augmented generation (RAG) has emerged as a way for companies to overcome these limitations. Using this advanced AI technique, enterprises can combine a pre-trained LLM such as ChatGPT with their own proprietary data to obtain accurate, contextually aware responses. They can restrict the data that’s used by pulling only from the most relevant sources such as approved company procedures, policies, or product information. And because RAG retrieves information in real time from a company’s vector database, they can make sure they always obtain the latest information as new data is added.

Combining the benefits of an LLM with company data

RAG effectively combines data retrieval with language generation. The retriever acts like a search engine that retrieves data based on a user’s query, using sophisticated algorithms to collect only the most relevant information. The generator is typically an LLM like ChatGPT that takes this information and turns it into an accurate, informed response. By integrating these two components, RAG makes it possible for companies to build customized AI systems that give them a competitive edge.

The potential applications are numerous. Sales and marketing teams can quickly combine information from market reports, customer feedback, and social media feeds to identify purchasing trends and customer preferences. Customer service teams can increase customer loyalty through RAG-powered chatbots that use product information, customer profiles, and purchase histories to provide personalized responses to customer inquiries. Legal teams can easily leverage the AI learnings from contracts, legal cases, and other documents when providing legal advice. By helping employees quickly and accurately tap into relevant, up-to-date structured and unstructured data stored across multiple databases, RAG can increase business productivity, improve the customer experience, and boost profits by reducing labor and enhancing customer loyalty.

Yet while RAG promises to transform enterprise AI, some roadblocks remain. One of the major hurdles is retrieving and integrating data across the distributed IT landscapes most companies have in place. Today, the majority of enterprises operate their applications across a highly complex hybrid, multicloud environment. And because data is typically stored in different places—including on-premises data centers and multiple clouds such as Microsoft Azure, Google Cloud Platform, and AWS—integrating all of this siloed data with an LLM can be difficult. Moreover, without the right protections, there’s the risk of exposing private information.

Implementing RAG across hybrid, multicloud environments

F5 has been working together with data infrastructure company NetApp to solve these problems. By integrating F5’s secure, high-performance multicloud networking capabilities with NetApp’s robust data management solutions, we’re making it possible to quickly retrieve company data no matter where it’s located and securely combine it with an LLM.

NetApp’s Cloud Volumes ONTAP and Azure NetApp Files optimize cloud storage costs and performance while enhancing data protection and compliance. When combined with F5 Distributed Cloud Network Connect, data can be quickly and securely connected and moved across zones and regions regardless of where it’s stored.

As businesses look for ways to deliver LLM applications that advance the business, our joint solution offers them a seamless way to manage, protect, and optimize their data, while at the same time reducing costs. Company data remains private. And users can obtain the accurate, timely, and context-relevant information they need to thrive in the digital age.

As F5’s Chief Technology and AI Officer Kunal Anand put it, “Our joint solution delivers unparalleled performance and ironclad security, enabling enterprises to confidently harness AI’s capabilities within their unique business contexts.”

Capturing the full promise of enterprise AI

This partnership builds on previous collaborations between F5 and NetApp to help companies connect their hybrid, multicloud environments. And it’s important to note that it’s just the beginning. Over the coming months, we will continue to work together to help enterprises capture the full power of AI across their distributed IT landscapes.

To learn more, please read our press release. Also, visit our F5 and NetApp webpage.

About the Author

Related Blog Posts

Why sub-optimal application delivery architecture costs more than you think

Discover the hidden performance, security, and operational costs of sub‑optimal application delivery—and how modern architectures address them.

Keyfactor + F5: Integrating digital trust in the F5 platform

By integrating digital trust solutions into F5 ADSP, Keyfactor and F5 redefine how organizations protect and deliver digital services at enterprise scale.

Architecting for AI: Secure, scalable, multicloud

Operationalize AI-era multicloud with F5 and Equinix. Explore scalable solutions for secure data flows, uniform policies, and governance across dynamic cloud environments.

Nutanix and F5 expand successful partnership to Kubernetes

Nutanix and F5 have a shared vision of simplifying IT management. The two are joining forces for a Kubernetes service that is backed by F5 NGINX Plus.

AppViewX + F5: Automating and orchestrating app delivery

As an F5 ADSP Select partner, AppViewX works with F5 to deliver a centralized orchestration solution to manage app services across distributed environments.

F5 NGINX Gateway Fabric is a certified solution for Red Hat OpenShift

F5 collaborates with Red Hat to deliver a solution that combines the high-performance app delivery of F5 NGINX with Red Hat OpenShift’s enterprise Kubernetes capabilities.